原文:Introducing Gemini: our largest and most capable AI model

Gemma 承载着对负责任 AI 开发的承诺,它采用了与 Gemini 模型相同的研究成果和技术基础。

黑色背景上,蓝色渐变中显现的“Gemma”字样和一颗具有设计感的火花图标。

在 Google,我们坚信使 AI 惠及每一个人的理念。我们在向开放社区贡献创新方面拥有悠久的历史,这包括了 Transformers、TensorFlow、BERT、T5、JAX、AlphaFold 以及 AlphaCode 等重大贡献。现在,我们激动地宣布,Google 将向开发者和研究者们推出新一代的开放模型,旨在支持他们以负责任的方式开发 AI。

Gemma 开放模型

Gemma 是由 Google DeepMind 及 Google 其他团队共同开发的,一系列轻量级、先进的开放模型,基于与 Gemini 模型相同的研究和技术。Gemma 不仅源自于 Gemini 的灵感,其名字在拉丁语中代表“宝石”,象征其珍贵和独特。除了模型权重,我们还提供了一系列工具,旨在支持开发者创新、促进合作,并确保 Gemma 模型的负责任使用。

从今日起,Gemma 将向全球用户开放。以下是一些关键信息:

我们推出了两种规模的模型权重:Gemma 2B 和 Gemma 7B,每种规模均提供了预先训练好的版本以及经过特殊优化的版本。

新推出的负责任的生成式 AI 工具包为开发更安全的 AI 应用提供了指南和必要的工具,特别适用于 Gemma。

我们为 JAX、PyTorch 和 TensorFlow 等所有主流开发框架提供了一套完整的工具,支持模型的推理操作和有监督的调优工作,全部通过最新的Keras 3.0版本实现。

借助即开即用的Colab和Kaggle Notebook,以及与Hugging Face、MaxText、NVIDIA NeMo和TensorRT-LLM等流行工具的无缝集成,轻松开始 Gemma 之旅。

经过预训练和特殊优化的 Gemma 模型能够在个人电脑、工作站或 Google Cloud 上运行,通过Vertex AI和Google Kubernetes Engine(GKE)实现简便部署。

针对多种 AI 硬件平台的优化工作确保了我们在行业中的领先性能,包括NVIDIA 的 GPU和Google Cloud 的 TPU。

使用条款支持所有机构负责任地进行商业使用和分发,不分大小。

尺寸级别的顶尖性能

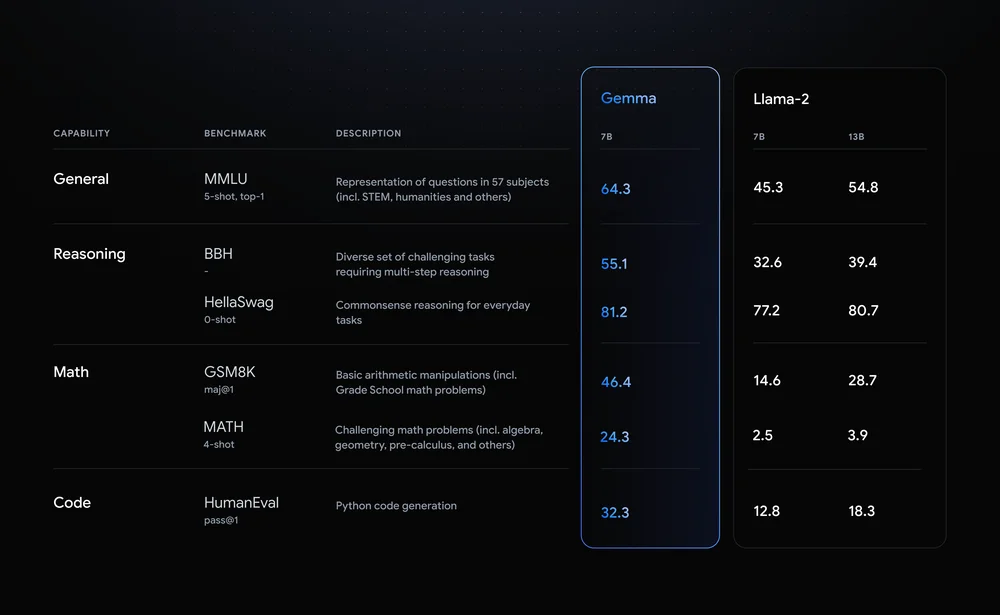

Gemma 模型与我们目前最大、最强大的 AI 模型——Gemini在技术和基础架构上有共享之处。这一共享使得 Gemma 2B 和 7B 能够在同类开放模型中,就其规模而言,展现出卓越的性能。更为重要的是,Gemma 模型甚至能直接运行在开发者的笔记本或台式机上。尤其值得一提的是,Gemma 在重要的基准测试上超越了体积更大的模型,同时严格遵循我们对输出安全和责任的高标准。想要了解更多关于性能、数据集构成以及建模方法的详细信息,请查阅技术报告。

展示 Gemma 在常用基准测试中的性能,与 Llama-2 的 7B 和 13B 版本进行了比较的图表

设计理念体现责任感

在设计 Gemma 时,我们将 AI 原则 置于首位。为确保 Gemma 预训练模型的安全与可靠,我们采用自动化技术筛除了训练集中的个人信息和其他敏感数据。此外,我们还广泛应用了微调技术和基于人类反馈的强化学习 (RLHF),以确保我们的模型行为与负责任的标准相符。为评估 Gemma 模型的风险程度,我们进行了全面的评估,包括手动红队测试、自动对抗测试和对模型进行危险活动能力的评估。这些评估工作已详细记录在我们的 模型卡 中。1

我们还发布了一套新的 负责任生成式 AI 工具包,与 Gemma 同时推出,旨在帮助开发者和研究人员构建既安全又负责任的 AI 应用。该工具包包括:

安全分类: 我们提供了一种新的方法,即使用最少的示例来构建健壮的安全分类器,详情见 这里。

调试工具: 通过 Gemma 调试工具,您可以深入了解 Gemma 的行为并解决潜在的问题。

指南: 基于谷歌在开发和部署大型语言模型方面的经验,我们提供了模型开发者的最佳实践指导。

跨平台、工具及硬件的深度优化

你可以根据自己的数据需求,对 Gemma 模型进行微调 (fine-tune),以便更好地适应特定的应用场景,如生成摘要或检索增强型生成 (RAG)。Gemma 支持包括但不限于以下工具和系统:

多框架支持工具:无论你偏爱哪种开发框架,Gemma 都提供了跨 Keras 3.0、PyTorch、JAX 及 Hugging Face Transformers 的推理和微调参考实现。

跨设备兼容:Gemma 模型能够在各种常见设备上运行,涵盖笔记本、台式机、物联网、移动设备以及云平台,旨在让 AI 技术的应用更加广泛和便捷。

尖端硬件平台合作:我们与 NVIDIA 携手,针对 NVIDIA GPU 从数据中心到云端乃至个人 RTX AI 电脑进行了专门优化,以确保提供行业领先的性能并充分利用最新技术。

针对 Google Cloud 的专项优化:Vertex AI 提供全面的 MLOps 工具集,支持多样化的调优选项和简便的一键部署,后者利用了内建的推理优化技术。用户还可以通过完全托管的 Vertex AI 工具或自主管理的 GKE,实现高级定制,包括向 GPU、TPU 和 CPU 等成本效益高的基础设施部署,不论使用哪个平台都行。

为研究和开发提供免费额度

Gemma 旨在为那些推动 AI 创新的开发者和研究人员社区提供支持。今天,你就可以开始使用 Gemma,在 Kaggle 上享受免费访问,在 Colab Notebook 上享受免费服务,以及为首次使用 Google Cloud 的用户提供的 300 美元额度。研究人员还可以申请高达 500,000 美元的 Google Cloud 额度,以加速他们的项目进展。

开始使用

通过访问 ai.google.dev/gemma,你可以深入了解 Gemma 并获取快速入门指南。

随着我们不断扩展 Gemma 模型系列,我们期待引入更多适合不同应用场景的新模型。请期待未来几周内的活动和机会,届时你将有机会更深入地了解、学习并使用 Gemma。

我们期待着见证你的创新成果!

评论